Garbage In – Garbage Out: Die Bedeutung von Datenqualität in der KI-Ära

- Johanna B. Mendes

- 20. Jan. 2024

- 5 Min. Lesezeit

Aktualisiert: 10. Nov. 2024

Garbage in - garbage out" – dieser altbekannte Grundsatz der Datenverarbeitung gewinnt in der Welt der Künstlichen Intelligenz (KI) des Jahres 2024 eine neue Dimension. In diesem Blogbeitrag werfen wir einen Blick auf die jüngsten Fortschritte in der KI-Technologie, die unsere Welt zunehmend prägen. Dabei liegt unser Fokus insbesondere auf der Qualität der Daten, die als Nährboden für diese fortschrittlichen Systeme dienen. Wir beleuchten, wie Datenqualität die Effizienz, Genauigkeit und Zuverlässigkeit von KI-Systemen beeinflusst und warum schlechte Daten unweigerlich zu unzuverlässigen Ergebnissen führen. Zudem diskutieren wir, wie führende Forscher und Entwickler auf dem Gebiet der KI daran arbeiten, die Herausforderungen im Umgang mit unzureichenden oder verzerrten Daten zu meistern. Abschließend betrachten wir, welche Auswirkungen dies für die Zukunft der KI und ihre Anwendung in verschiedenen Branchen hat.

Daten sind das Lebenselixier der KI - sie sind das Fundament, auf dem Algorithmen trainiert werden, Entscheidungen treffen und lernen. Die Qualität dieser Daten bestimmt direkt die Leistungsfähigkeit und Präzision der KI-Systeme. KI-Modelle, die mit fehlerhaften, verzerrten oder unvollständigen Daten gefüttert werden, führen zu gravierend fehlerhaften Ergebnissen. Dies kann in kritischen Anwendungen wie der Medizin, dem Finanzwesen oder der autonomen Fahrzeugsteuerung katastrophale Folgen haben. Wir beleuchten, wie das Sprichwort "garbage in – garbage out" in der KI eine buchstäbliche Bedeutung annimmt: Eine KI ist nur so gut wie die Daten, mit denen sie trainiert wird. Hierbei zeigen wir auf, wie die Vernachlässigung der Datenqualität nicht nur die Funktionalität der KI beeinträchtigt, sondern auch ethische und gesellschaftliche Risiken birgt.

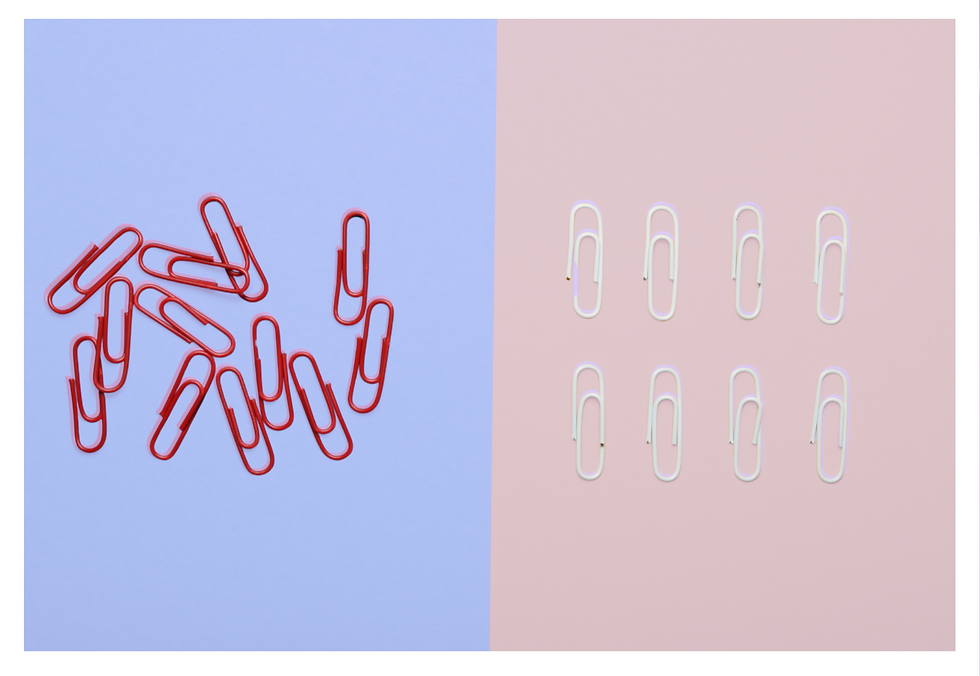

garbage in - garbage out

Das Prinzip "Garbage in - Garbage out" ist ein fundamentales Konzept in der Datenwissenschaft, das besagt, dass die Qualität der Ausgabe direkt von der Qualität der Eingabedaten abhängt. In der KI bedeutet dies, dass Algorithmen, die mit fehlerhaften, unvollständigen oder irreführenden Daten trainiert werden, unzuverlässige oder fehlerhafte Ergebnisse liefern. Zum Beispiel kann eine KI, die für die Gesichtserkennung entwickelt wurde, aber nur mit Bildern einer bestimmten demografischen Gruppe trainiert wurde, Schwierigkeiten haben, Gesichter aus anderen Gruppen korrekt zu identifizieren. Ebenso kann ein Sprachverarbeitungsmodell, das auf schlecht transkribierten Texten basiert, zu Fehlinterpretationen und Missverständnissen führen. Dieses Prinzip unterstreicht die Notwendigkeit sorgfältiger Datensammlung und -prüfung, um sicherzustellen, dass KI-Systeme präzise und gerechte Ergebnisse liefern.

Die Kunst der Datenaufbereitung

Die Datenaufbereitung ist ein kritischer Prozess in des Datenmanagement, besonders im Bereich der KI, und umfasst mehrere Schlüsselschritte:

Datensammlung: Der erste Schritt ist die Sammlung von Daten aus verschiedenen Quellen. Hierbei ist es wichtig, auf eine ausgewogene und repräsentative Datenmenge zu achten, um Verzerrungen zu vermeiden.

Datenbereinigung: Diese Phase beinhaltet das Identifizieren und Korrigieren von Fehlern und Inkonsistenzen in den Daten, wie z.B. fehlende Werte, Duplikate oder fehlerhafte Einträge.

Datenexploration und -analyse: In diesem Schritt werden die Daten untersucht, um ein tieferes Verständnis zu gewinnen. Methoden der deskriptiven Statistik und Datenvisualisierung werden oft verwendet, um Muster und Anomalien zu erkennen.

Datentransformation: Die Daten werden in ein Format umgewandelt, das für die Verarbeitung durch KI-Modelle geeignet ist. Dazu gehören Normalisierung, Skalierung und Kodierung von kategorischen Daten.

Feature-Auswahl und -engineering: Hier werden relevante Merkmale (Features) ausgewählt oder neue Merkmale aus den vorhandenen Daten erstellt, um die Leistung des KI-Modells zu verbessern.

Datenteilung: Die Daten werden in Trainings-, Validierungs- und Testsets aufgeteilt, um das Modell zu trainieren und seine Leistung zu bewerten.

Zur Sicherstellung der Datenintegrität und um die Qualität und Zuverlässigkeit von Daten zu gewährleisten, ist eine regelmäßige Überprüfung unerlässlich. Dies bedeutet, dass Daten kontinuierlich auf Fehler und Inkonsistenzen geprüft werden sollten, um sicherzustellen, dass sie korrekt und aktuell sind. Ebenso wichtig ist eine sorgfältige Dokumentation der Datenquellen und des Aufbereitungsprozesses. Eine gut geführte Dokumentation sorgt für Nachvollziehbarkeit und ermöglicht es, den Ursprung und die Verarbeitungsschritte der Daten jederzeit zu rekonstruieren, was für die Reproduzierbarkeit von Ergebnissen entscheidend ist.

Die Diversität der Datenquellen sind von großer Bedeutung. Indem man auf eine breite Palette verschiedener Datenquellen zurückgreift, können Verzerrungen minimiert und die Generalisierbarkeit von Modellen erhöht werden. Dies trägt dazu bei, dass die Ergebnisse der Datenanalyse ein realistisches und umfassendes Bild der zugrundeliegenden Sachverhalte liefern.

Insgesamt ist die Pflege der Datenqualität ein vielschichtiger Prozess, der regelmäßige Überprüfungen, eine sorgfältige Dokumentation und die Nutzung diverser Datenquellen umfasst. Diese Maßnahmen sind entscheidend, um die Integrität und Zuverlässigkeit der Daten zu gewährleisten.

Um die Qualität von Daten effektiv zu bewerten, stehen zahlreiche Metriken zur Verfügung, die speziell darauf ausgerichtet sind, verschiedene Aspekte der Datenqualität zu messen. Diese Metriken sind unerlässlich, um den Fortschritt zu verfolgen und sicherzustellen, dass kontinuierliche Verbesserungen im Umgang mit Daten erzielt werden.

Metriken zu Messung von Datenqualität

Die Bewertung der Datenqualität ist ein wesentlicher Bestandteil der Datenaufbereitung, insbesondere in der Künstlichen Intelligenz. Es gibt verschiedene Metriken und Tools, die dabei helfen können, die Datenqualität zu messen und zu verbessern.

Hier sind einige davon:

Vollständigkeit: Diese Metrik bewertet, ob alle erforderlichen Daten vorhanden sind. Fehlende Werte können mittels Imputation (Ersetzung fehlender Daten) behandelt werden.

Konsistenz: Überprüft, ob die Daten logisch konsistent sind und keine Widersprüche aufweisen. Datenvalidierungstools können verwendet werden, um Inkonsistenzen zu identifizieren.

Genauigkeit: Diese Metrik misst, wie genau die Daten die Realität abbilden. Zur Überprüfung der Genauigkeit kann ein Abgleich mit bekannten Referenzdaten erfolgen.

Aktualität: Misst, ob die Daten aktuell sind. Dies ist besonders wichtig in dynamischen Bereichen, wo sich Daten schnell ändern können.

Einzigartigkeit: Überprüft, ob die Daten Duplikate enthalten. Tools zur Datenbereinigung können hier zum Einsatz kommen, um doppelte Einträge zu entfernen.

Durch die Anwendung dieser Metriken können Unternehmen und Datenmanager sicherstellen, dass ihre Daten die höchstmögliche Qualität aufweisen, was wiederum zu verlässlicheren und effektiveren KI-Systemen führt.

Die Zukunft der Künstlichen Intelligenz (KI) ist eng mit der Qualität der Daten verknüpft, die wir bereitstellen. Als immer ausgefeilteres Werkzeug prägt die KI zunehmend unsere Gesellschaft, Wirtschaft und unser tägliches Leben. Die Bedeutung von Datenqualität für den Erfolg von KI-Anwendungen in Bereichen wie Medizin, städtische Planung und Umweltüberwachung kann nicht genug betont werden. Hochwertige Daten sind das Fundament für genaue und zuverlässige KI-Systeme.

In einer Welt, in der KI vermehrt Entscheidungen trifft, wird die Gewährleistung der Datenqualität zur ethischen Notwendigkeit. Unzureichende Daten können zu fehlerhaften Entscheidungen führen, die schwerwiegende Folgen haben können. Daher ist es entscheidend, dass wir uns der Verantwortung für die Pflege und Verbesserung der Datenqualität bewusst sind.

Dies ist kein einmaliger Prozess, sondern eine kontinuierliche Anstrengung, die die Überprüfung und Verbesserung der Datenqualität durch Standards, Audits und fortschrittliche Analysetools umfasst. Investitionen in hochwertige Daten bieten nicht nur interne Verbesserungen, sondern auch signifikante Wettbewerbsvorteile. Lassen Sie uns Datenqualität priorisieren und gemeinsam in eine Zukunft investieren, die durch präzise und aussagekräftige Daten bereichert wird.

Die Verbesserung der Datenqualität in deinem Unternehmen erfordert keine umfassenden IT-Kenntnisse oder langwierige Einarbeitung.

Über die Autorin:

Als erfahrene Datenmanagement- und Data-Governance-Expertin mit über sieben Jahren Berufserfahrung begleitet Johanna B. Mendes Unternehmen durch den digitalen Wandel und gestaltet datengetriebene Unternehmensstrategien mit.

Sie ist überzeugt, dass soziale Kompetenzen der entscheidende Erfolgsfaktor sind, um die digitale Welt aktiv zu gestalten.

.png)

Kommentare